Знам че има много подобни статии в интернет, но в моя блог няма нито една за LVM, и заради това сега ще напиша и първата такава! 🙂

Онзи ден трябваше да добавя 2 нови 500GB WD към сървъра „heaven“ и да ги вкарам в LVM „/dev/mapper/pve-data“

За целта първо добавих двата хард диска в LVM таблицата чрез:

heaven:~# pvcreate /dev/sdb

Physical volume "/dev/sdb" successfully created

heaven:~# pvcreate /dev/sdc

Physical volume "/dev/sdc" successfully created

а след това добавих двата харда в предварително създадената ни от proxmox-a група „pve“

heaven:~# vgextend pve /dev/sdb

Volume group "pve" successfully extended

heaven:~# vgextend pve /dev/sdc

Volume group "pve" successfully extended

ВАЖНО!!

Когато използваме не целият хард диск, а отделни партишъни, и по една или друга причина линукса ни не открива новите дялове, е необходимо да се пусне ръчно „partprobe“ която проверява за промени по дяловата таблица. Много е важно това!

Чрез командата vgdisplay можем да видим колко LVM групи имаме в момента

heaven:~# vgdisplay

--- Volume group ---

VG Name pve

System ID

Format lvm2

Metadata Areas 3

Metadata Sequence No 12

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 3

Open LV 3

Max PV 0

Cur PV 3

Act PV 3

VG Size 1.49 TiB

PE Size 4.00 MiB

Total PE 390959

Alloc PE / Size 389037 / 1.48 TiB

Free PE / Size 1922 / 7.51 GiB

VG UUID wy2dkr-S89P-FnAS-CoWp-QPJb-guqv-MU2jiO

Чрез командите lvdisplay или lvscan ние можем да видим колко логически групи имаме в момента и какво е тяхното състояние.

heaven:~# lvscan

ACTIVE '/dev/pve/swap' [9.00 GiB] inherit

ACTIVE '/dev/pve/root' [96.00 GiB] inherit

ACTIVE '/dev/pve/data' [1.38 TiB] inherit

Тук вече съм добавил 2та WD в групата. За съмото добавяне на 2х500гб използвах следната команда:

lvextend -L+940G /dev/mapper/pve-data

Като по този начин добавих 940 GB към сегашните ми ~640GB.

Накрая за да влезе всичко това в сила, беше необходимо да напиша и това:

heaven:~# resize2fs /dev/mapper/pve-data

И така в крайна сметка състоянието на хард дисковете ми в момента е следното:

heaven:~# df -h

Filesystem Size Used Avail Use% Mounted on

udev 10M 0 10M 0% /dev

tmpfs 1000M 2.2M 998M 1% /run

/dev/mapper/pve-root 95G 11G 79G 13% /

tmpfs 5.0M 0 5.0M 0% /run/lock

tmpfs 2.0G 22M 2.0G 2% /run/shm

/dev/mapper/pve-data 1.4T 464G 930G 34% /var/lib/vz

/dev/sda1 495M 36M 435M 8% /boot

/dev/fuse 30M 20K 30M 1% /etc/pve

Моят съвет е да използваме RAID контролер и новите ни хард дискове предварително да сме ги добавили в RAID (1) примерно или (5) ако имаме повече от 2 хард диска. Така освен че ще имаме повече място, ще сме сигурни в системата си от евентуален счупен хард диск и загуба на информация.

Какво е

Какво е

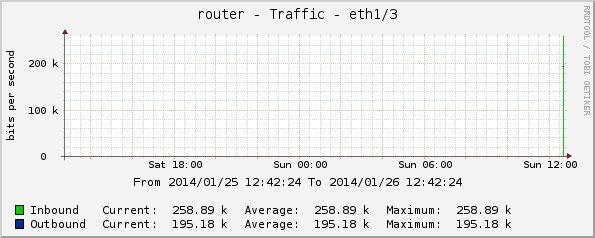

Днес ми се случи нещо много интересно свързано с един виртуален сървър на

Днес ми се случи нещо много интересно свързано с един виртуален сървър на